для каких задач могут использовать глубокое обучение

Глубокое обучение (Deep Learning): обзор

Всем привет. Уже в этом месяце в ОТУС стартует новый курс — «Математика для Data Science». В преддверии старта данного курса традиционно делимся с вами переводом интересного материала.

Аннотация. Глубокое обучение является передовой областью исследований машинного обучения (machine learning — ML). Оно представляет из себя нескольких скрытых слоев искусственных нейронных сетей. Методология глубокого обучения применяет нелинейные преобразования и модельные абстракции высокого уровня на больших базах данных. Последние достижения во внедрении архитектуры глубокого обучения в многочисленных областях уже внесли значительный вклад в развитие искусственного интеллекта. В этой статье представлено современное исследование о вкладе и новых применениях глубокого обучения. Следующий обзор в хронологическом порядке представляет, как и в каких наиболее значимых приложениях использовались алгоритмы глубокого обучения. Кроме того, представлены выгода и преимущества методологии глубокого обучения в ее многослойной иерархии и нелинейных операциях, которые сравниваются с более традиционными алгоритмами в обычных приложениях. Обзор последних достижений в области далее раскрывает общие концепции, постоянно растущие преимущества и популярность глубокого обучения.

1. Введение

Искусственный интеллект (ИИ) как интеллект, демонстрируемый машинами, является эффективным подходом к пониманию человеческого обучения и формирования рассуждений [1]. В 1950 году «Тест Тьюринга» был предложен как удовлетворительное объяснение того, как компьютер может воспроизводить когнитивные рассуждения человека [2]. Как область исследований, ИИ делится на более конкретные подобласти. Например: обработка естественного языка (Natural Language Processing — NLP) [3] может улучшить качество письма в различных приложениях [4,17]. Самым классическим подразделением в NLP является машинный перевод, под которым понимают переводом между языками. Алгоритмы машинного перевода способствовали появлению различных приложений, которые учитывают грамматическую структуру и орфографические ошибки. Более того, набор слов и словарный запас, относящиеся к теме материала, автоматически используются в качестве основного источника, когда компьютер предлагает изменения для автора или редактора [5]. На рис. 1 подробно показано, как ИИ охватывает семь областей компьютерных наук.

В последнее время машинное обучение и интеллектуальный анализ данных попали в центр внимания и стали наиболее популярными темами среди исследовательского сообщества. Совокупность этих областей исследования анализируют множество возможностей характеризации баз данных [9]. На протяжении многих лет базы данных собирались в статистических целях. Статистические кривые могут описывать прошлое и настоящее, чтобы предсказывать будущие модели поведения. Тем не менее, в течение последних десятилетий для обработки этих данных использовались только классические методы и алгоритмы, тогда как оптимизация этих алгоритмов могла бы лечь в основу эффективного самообучения [19]. Улучшенный процесс принятия решений может быть реализован на основе существующих значений, нескольких критериев и расширенных методов статистики. Таким образом, одним из наиболее важных применений этой оптимизации является медицина, где симптомы, причины и медицинские решения создают большие базы данных, которые можно использовать для определения лучшего лечения [11].

Рис. 1. Исследования в области искусственного интеллекта (ИИ) Источник: [1].

Поскольку ML охватывает широкий спектр исследований, на данный момент уже разработано множество подходов. Кластеризация, байесовская сеть, глубокое обучение и анализ дерева решений — это только их часть. Следующий обзор в основном фокусируется на глубоком обучении, его основных понятиях, проверенных и современных применениях в различных областях. Кроме того, в нем представлены несколько рисунков, отражающих стремительный рост публикаций с исследованиями в области глубокого обучения за последние годы в научных базах данных.

2. Теоретические основы

Концепция глубокого обучения (Deep Learning — DL) впервые появилась в 2006 году как новая область исследований в машинном обучении. Вначале оно было известно как иерархическое обучение в [2], и как правило оно включало в себя множество областей исследований, связанных с распознаванием образов. Глубокое обучение в основном принимает в расчет два ключевых фактора: нелинейная обработка в нескольких слоях или стадиях и обучение под наблюдением или без него [4]. Нелинейная обработка в нескольких слоях относится к алгоритму, в котором текущий слой принимает в качестве входных данных выходные данные предыдущего слоя. Иерархия устанавливается между слоями, чтобы упорядочить важность данных, полезность которых следует установить. С другой стороны, контролируемое и неконтролируемое обучение связано с меткой классов целей: ее присутствие подразумевает контролируемую систему, а отсутствие — неконтролируемую.

3. Применения

Глубокое обучение подразумевает слои абстрактного анализа и иерархические методы. Тем не менее, оно может быть использовано в многочисленных реальных приложениях. Как пример, в цифровой обработке изображений; раскраска черно-белых изображений раньше выполнялась вручную пользователями, которым приходилось выбирать каждый цвет на основе своего собственного суждения. Применяя алгоритм глубокого обучения, раскраска может выполняться автоматически с помощью компьютера [10]. Точно так же звук может быть добавлен в видео с игрой на барабанах без звука с использованием рекуррентных нейронных сетей (Recurrent Neural Networks — RNN), которые являются частью методов глубокого обучения [18].

Глубокое обучение может быть представлено как метод улучшения результатов и оптимизации времени обработки в нескольких вычислительных процессах. В области обработки естественного языка методы глубокого обучения были применены для создания подписей к изображениям [20] и генерации рукописного текста [6]. Следующие применения детальнее классифицированы в таких областях как цифровая обработка изображений, медицина и биометрия.

3.1 Обработка изображений

До того, как глубокое обучение официально утвердилось в качестве нового исследовательского подхода, некоторые приложения были реализованы в рамках концепции распознавания образов посредством обработки слоев. В 2003 году был разработан интересный пример с применением фильтрации частиц и алгоритма распространения доверия (Bayesian – belief propagation). Основная концепция этого приложения полагает, что человек может распознавать лицо другого человека, наблюдая только половину изображения лица [14], поэтому компьютер может восстановить изображение лица из обрезанного изображения.

Позже в 2006 году жадный алгоритм и иерархия были объединены в приложение, способное обрабатывать рукописные цифры [7]. Недавние исследования применили глубокое обучение в качестве основного инструмента для цифровой обработки изображений. Например, применение сверточных нейронных сетей (Convolutional Neural Networks — CNN) для распознавания радужной оболочки может быть более эффективным, чем использование привычных датчиков. Эффективность CNN может достигать 99,35% точности [16].

Мобильное распознавание местоположения в настоящее время позволяет пользователю узнать определенный адрес на основе изображения. Алгоритм SSPDH (Supervised Semantics – Preserving Deep Hashing) оказался значительным улучшением по сравнению VHB (Visual Hash Bit) и SSFS (Space – Saliency Fingerprint Selection). Точность SSPDH аж на 70% эффективнее [15].

Наконец, еще одно замечательное применение в цифровой обработке изображений с использованием метода глубокого обучения — распознавание лиц. Google, Facebook и Microsoft имеют уникальные модели распознавания лиц с глубоким обучением [8]. В последнее время идентификация на основе изображения лица изменилась на автоматическое распознавание путем определения возраста и пола в качестве исходных параметров. Sighthound Inc., например, тестировали алгоритм глубокой сверточной нейронной сети, способный распознавать не только возраст и пол, но даже эмоции [3]. Кроме того, была разработана надежная система для точного определения возраста и пола человека по одному изображению путем применения архитектуры глубокого многозадачного обучения [21].

3.2 Медицина

Цифровая обработка изображений, несомненно, является важной частью исследовательских областей, где может применяться метод глубокого обучения. Таким же образом, недавно тестировались клинические приложения. Например, сравнение между малослойным обучением и глубоким обучением в нейронных сетях привело к лучшей эффективности в прогнозировании заболеваний. Изображение, полученное с помощью магнитно-резонансной томографии (МРТ) [22] из головного мозга человека, было обработано, чтобы предсказать возможную болезнь Альцгеймера [3]. Не смотря на быстрый успех этой процедуры, некоторые проблемы должны быть серьезно рассмотрены для будущих применений. Одними из ограничений являются тренировка и зависимость от высокого качества. Объем, качество и сложность данных являются сложными аспектами, однако интеграция разнородных типов данных является потенциальным аспектом архитектуры глубокого обучения [17, 23].

Оптическая когерентная томография (ОКТ) является еще одним примером, где методы глубокого обучения показывают весомые результаты. Традиционно изображения обрабатываются путем ручной разработки сверточных матриц [12]. К сожалению, отсутствие учебных наборов ограничивает метод глубокого обучения. Тем не менее, в течение нескольких лет внедрение улучшенных тренировочных наборов будет эффективно предсказывать патологии сетчатки и уменьшать стоимость технологии ОКТ [24].

3.3 Биометрия

В 2009 году было применено приложение для автоматического распознавания речи, чтобы уменьшить частоту телефонных ошибок (Phone Error Rate — PER) с использованием двух разных архитектур сетей глубокого доверия [18]. В 2012 году метод CNN [25] был применен в рамках гибридной нейронной сети — скрытой модели маркова (Hybrid Neural Network — Hidden Markov Model — NN — HMM). В результате был достигнут PER на уровне 20,07%. Полученный PER лучше по сравнению с ранее применяемым 3-слойным методом базовой линии нейронной сети [26]. Смартфоны и разрешение их камер были протестированы для распознавания радужной оболочки. При использовании мобильных телефонов, разработанных различными компаниями, точность распознавания радужной оболочки может достигать до 87% эффективности [22,28].

С точки зрения безопасности, особенно контроля доступа; глубокое обучение используется в сочетании с биометрическими характеристиками. DL был использован для ускорения разработки и оптимизации устройств распознавания лиц FaceSentinel. По словам этого производителя, их устройства могут расширить процесс идентификации с одного-к-одному до одного-к-многим за девять месяцев [27]. Это усовершенствование движка могло бы занять 10 человеко-лет без внедрения DL. Что ускорило производство и запуск оборудования. Эти устройства используются в лондонском аэропорту Хитроу, а также могут использоваться для учета рабочего времени и посещаемости, и в банковском секторе [3, 29].

4. Обзор

Таблица 1 подытоживает несколько применений, реализованных в течение предыдущих лет относительно глубокого обучения. В основном упоминаются распознавание речи и обработка изображений. В этом обзоре рассматриваются только некоторые из большого списка применений.

Таблица 1. Применения глубокого обучения, 2003–2017 гг.

(Применение: 2003 — Иерархический байесовский вывод в зрительной коре; 2006 — Классификация цифр; 2006 — Глубокая сеть доверия для телефонного распознавания; 2012 — Распознавание речи из множественных источников; 2015 — Распознавание радужки глаза с помощью камер смартфонов; 2016 — Освоение игры Го глубокими нейронными сетями с поиском по дереву; 2017 — Модель сенсорного распознавания радужки).

4.1 Анализ публикаций за год

На рис. 1 приведено количество публикаций по глубокому обучению из базы данных ScienceDirect в год с 2006 по июнь 2017 года. Очевидно, что постепенное увеличение числа публикаций мог бы описать экспоненциальный рост.

На рис. 2 представлено общее количество публикаций по глубокому обучению в Springer в год с января 2006 года по июнь 2017 года. В 2016 году наблюдается внезапный рост публикаций, достигающий 706 публикаций, что доказывает, что глубокое обучение действительно в центре внимания современных исследований.

На рис. 3 показано количество публикаций на конференциях, в журналах и изданиях IEEE с января 2006 года по июнь 2017 года. Примечательно, что с 2015 года количество публикаций значительно увеличилось. Разница между 2016 и 2015 годами составляет более 200% прироста.

Рис. 1. Рост количества публикаций по глубокому обучению в базе данных Sciencedirect (январь 2006 г. — июнь 2017 г.)

Рис. 2. Рост количества публикаций по глубокому обучению из базы данных Springer. (январь 2006 г. — июнь 2017 г.)

Рис. 3. Рост публикаций в по глубокому обучению из базы данных IEEE. (январь 2006 г. — июнь 2017 г.)

5. Выводы

Глубокое обучение — действительно быстро растущее применение машинного обучения. Многочисленные приложения, описанные выше, доказывают его стремительное развитие всего за несколько лет. Использование этих алгоритмов в разных областях показывает его универсальность. Анализ публикаций, выполненный в этом исследовании, ясно демонстрирует актуальность этой технологии и дает четкую иллюстрацию роста глубокого обучения и тенденций в отношении будущих исследований в этой области.

Кроме того, важно отметить, что иерархия уровней и контроль в обучении являются ключевыми факторами для разработки успешного приложения в отношении глубокого обучения. Иерархия важна для соответствующей классификации данных, в то время как контроль учитывает важность самой базы данных как части процесса. Основная ценность глубокого обучения заключается в оптимизации существующих приложений в машинном обучении благодаря инновационности иерархической обработки. Глубокое обучение может обеспечить эффективные результаты при цифровой обработке изображений и распознавании речи. Снижение процента ошибок (от 10 до 20%) явно подтверждает улучшение по сравнению с существующими и проверенными методами.

В нынешнюю эпоху и в будущем глубокое обучение может стать полезным инструментом безопасности благодаря сочетанию распознавания лиц и речи. Помимо этого, цифровая обработка изображений является областью исследований, которая может применяться в множестве других областей. По этой причине и доказав истинную оптимизацию, глубокое обучение является современным и интересным предметом развития искусственного интеллекта.

Deep Learning: как это работает? Часть 1

В этой статье вы узнаете

-В чем суть глубокого обучения

-Для чего нужны функции активации

-Какие задачи может решать FCNN

-Каковы недостатки FCNN и с помощью чего с ними бороться

Небольшое вступление

Это начало цикла статей о том, какие задачи есть в DL, сети, архитектуры, принципы работы, как решаются те или иные задачи и почему одно лучше другого.

Какие предварительные навыки для понимания всего нужны? Сказать сложно, но если вы умеете гуглить или правильно задавать вопросы, то, я уверен, мой цикл статей поможет разобраться во многом.

В чем вообще суть глубокого обучения?

Суть в том, чтобы построить некий алгоритм, который принимал бы на вход X и предсказывал Y. Если мы пишем алгоритм Евклида для поиска НОД, то мы просто напишем циклы, условия, присваивания и вот это вот все — мы знаем как построить такой алгоритм. А как построить алгоритм, который на вход принимает изображение и говорит собака там или кошка? Или вовсе ничего? А алгоритм, на вход которого мы подаем текст и хотим узнать — какого он жанра? Вот так просто ручками написать циклы и условия тут не выйдет — тут на помощь и приходят нейронные сети, глубокое обучение и все вот эти модные слова.

Более формально и чуть-чуть о функциях активации

Выражаясь формально, мы хотим построить функцию от функции от функции…от входного параметра X и весов нашей сети W, которая выдавала бы нам некий результат. Тут важно отметить, что мы не можем взять просто много линейных функций, т.к. суперпозиция линейных функций — линейная функция. Тогда любая глубокая сеть аналогична сети с двумя слоями (входом и выходом). Для чего нам нелинейность? Наши параметры, которые мы хотим научиться предсказывать, могут нелинейно зависеть от входных данных. Нелинейность достигается путем использования различных функций активаций на каждом слое.

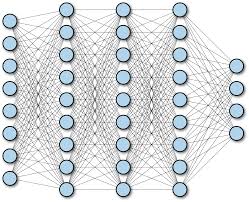

Fully-connected neural networks(FCNN)

Просто полносвязная нейронная сеть. Выглядит как-то так:

Суть в том, что каждый нейрон одного слоя связан с каждым нейроном следующего и предыдущего (если они есть).

Первый слой — входной. Например, если мы хотим подать изображение 256x256x3 на вход такой сети, то ровно 256x256x3 нейронов во входном слое нам и понадобится (каждый нейрон будет принимать 1 компоненту (R, G или B) пикселя). Если хотим подать рост человека, его вес и еще 23 признака, то понадобится 25 нейронов во входном слое. Кол-во нейронов на выходе — кол-во признаков, которые мы хотим предсказать. Это может быть как 1 признак, так и все 100. В общем случае по выходному слою сети можно почти наверняка сказать — какую задачу она решает.

Каждая связь между нейронами — вес, который тренируется алгоритмом backpropagation, о котором я писал тут.

Какие задачи может решать FCNN

-Задача регрессии. Например, предсказание стоимости магазина по каким-то входным критериям типа страны, города, улицы, проходимости и т.п.

-Задача классификации. Например, классика — MNIST classification.

-Насчет задачи сегментации и обнаружения объектов с помощью FCNN я сказать не возьмусь. Быть может, кто-то поделится в комментариях 🙂

Недостатки FCNN

Глубинное обучение: возможности, перспективы и немного истории

Последние несколько лет словосочетание «глубинное обучение» всплывает в СМИ слишком часто. Различные журналы вроде KDnuggets и DigitalTrends стараются не упустить новости из этой сферы и рассказать о популярных фреймворках и библиотеках.

Даже популярные издания вроде The NY Times и Forbes стремятся регулярно писать о том, чем заняты ученые и разработчики из области deep learning. И интерес к глубинному обучению до сих пор не угасает. Сегодня мы расскажем о том, на что способно глубинное обучение сейчас, и по какому сценарию оно будет развиваться в будущем.

Пара слов про глубинное обучение, нейронные сети и ИИ

Чем отличается алгоритм глубинного обучения от обычной нейронной сети? По словам Патрика Холла, ведущего исследователя данных в компании SAS, самое очевидное отличие: в нейронной сети, используемой в глубинном обучении, больше скрытых слоев. Эти слои находятся между первым, или входным, и последним, выходным, слоем нейронов. При этом совсем не обязательно связывать все нейроны на разных уровнях между собой.

Разграничение глубинного обучения и искусственного интеллекта не такое однозначное. Например, профессор Вашингтонского университета Педро Домингос соглашается с мнением, что глубинное обучение выступает гипонимом по отношению к термину «машинное обучение», которое в свою очередь является гипонимом по отношению к искусственному интеллекту. Домингос говорит, что на практике области их применения пересекаются достаточно редко.

Однако существует и другое мнение. Хуго Ларочелле, профессор Шербрукского университета, уверен, что данные концепты почти никак не связаны между собой. Хуго замечает, что ИИ фокусируется на цели, а глубинное обучение — на определенной технологии или методологии, необходимой для машинного обучения. Поэтому здесь и далее, говоря о достижениях в области ИИ (таких, как AlphaGo, например) будем иметь в виду, что подобные разработки используют алгоритмы глубинного обучения — но наряду и с другими разработками из области ИИ в целом и машинного обучения в частности [как справедливо отмечает Педро Домингос].

От «глубокой нейронной сети» до глубинного обучения

Глубокие нейронные сети появились достаточно давно, еще в 1980-е. Так почему же глубинное обучение начало активно развиваться только в 21 веке? Репрезентации в нейронной сети создаются в слоях, поэтому было логично предположить, что больше слоев позволит сети лучше обучаться. Но большую роль играет метод обучения сети. Раньше для глубинного обучения использовались те же алгоритмы, что и для обучения искусственных нейронных сетей — метод обратного шифрования. Такой метод мог эффективно обучать только последние слои сети, в результате чего процесс был чрезвычайно длительным, а скрытые слои глубинной нейронной сети, фактически, не «работали».

Только в 2006 году три независимых группы ученых смогли разработать способы преодоления трудностей. Джеффри Хинтон смог провести предобучение сети при помощи машины Больцмана, обучая каждый слой отдельно. Для решения проблем распознавания изображений Яном ЛеКаном было предложено использование сверточной нейронной сети, состоящей из сверточных слоев и слоев подвыборки. Каскадный автокодировщик, разработанный Иошуа Бенджио, также позволил задействовать все слои в глубокой нейронной сети.

Проекты, которые «видят» и «слышат»

Сегодня глубинное обучение используется в совершенно разных сферах, но, пожалуй больше всего примеров использования лежит в области обработки изображений. Функция распознавания лиц существует уже давно, но, как говорится, нет предела совершенству. Разработчики сервиса OpenFace уверены, что проблема еще не решена, ведь точность распознавания можно повысить. И это не просто слова, OpenFace умеет различать даже похожих внешне людей. Подробно о работе программы уже писали в этой статье. Глубинное обучение поможет и при работе с черно-белыми файлами, автоматической колоризацией которых занимается приложение Colornet.

Кроме того, глубокие сети теперь способны распознавать и человеческие эмоции. А вместе с возможностью отследить использование логотипа компании на фотографиях и анализом сопроводительного текста мы получаем мощный маркетинговый инструмент. Похожие сервисы разрабатывает, например, IBM. Инструмент позволяет оценить авторов текстов при поиске блогеров для сотрудничества и рекламы.

Программа NeuralTalk умеет описывать изображения при помощи нескольких предложений. В базу программы загружается набор изображений и 5 предложений, описывающих каждое из них. На стадии обучения алгоритм учится прогнозировать предложения на основе ключевого слова, используя предыдущий контекст. А на стадии прогнозирования нейронная сеть Джордана уже создает предложения, описывающие картинки.

Сегодня существует много приложений, которые могут решать разные задачи в работе с аудио. Например, приложение Magenta, разработанное командой Google, умеет создавать музыку. Но большая часть приложений направлена на распознавание речи. Интернет-сервис Google Voice умеет транскрибировать голосовую почту и имеет функции управления СМС, при этом для обучения глубоких сетей исследователями использовались существующие голосовые сообщения.

Проекты в «разговорном жанре»

По мнению таких ученых, как Ноам Хомски, невозможно научить компьютер полностью понимать речь и вести осознанный диалог, потому что даже механизм человеческой речи изучен не до конца. Попытки научить машины говорить начались еще в 1968 году, когда Терри Виноград создал программу SHRDLU. Она умела распознавать части речи, описывать предметы, отвечать на вопросы, даже обладала небольшой памятью. Но попытки расширить словарный запас машины привели к тому, что стало невозможно контролировать применение правил.

Но сегодня с помощью глубинного обучения Google в лице разработчика Куока Ле шагнул далеко вперед. Его разработки умеют отвечать на письма в Gmail и даже помогают специалистам технической поддержки Google. А программа Cleverbot обучалась на диалогах из 18 900 фильмов. Поэтому она может отвечать на вопросы даже о смысле жизни. Так, бот считает, что смысл жизни заключается в служении добру. Однако ученые вновь столкнулись с тем, что искусственный интеллект лишь имитирует понимание и не имеет представления о реальности. Программа воспринимает речь лишь как сочетание определенных символов.

Обучение машин языку может помочь и в переводе. Google давно занимается улучшением качества перевода в своем сервисе. Но насколько можно приблизить машинный перевод к идеалу, если и человек не всегда может правильно понимать смысл высказывания? Рэй Курцвейл предлагает для решения этой задачи графически представить семантическое значение слов в языке. Процесс достаточно трудоемкий: в специальный каталог Knowledge Graph, созданный в Google, ученые загрузили данные о почти 700 миллионах тем, мест, людей, между которыми было проведено почти миллиард различных связей. Все это направлено на улучшение качества перевода и восприятие искусственным интеллектом языка.

Сама идея о представлении языка графическими и/или математическими методами не нова. Еще в 80-е перед учеными стояла задача представить язык в формате, с которым могла бы работать нейронная сеть. В итоге был предложен вариант представления слов в виде математических векторов, что позволяло точно определить смысловую близость разных слов (например, в векторном пространстве слова «лодка» и «вода» должны быть близки друг к другу). На этих исследованиях и базируются сегодняшние разработки Google, которые современные исследователи называют уже не «векторами отдельных слов», а «векторами идей».

Глубинное обучение и здравоохранение

Сегодня глубинное обучение проникает даже в сферу здравоохранения и помогает следить за состоянием пациентов не хуже врачей. Например, медицинский центр Дармут-Хичкок в США использует специализированный сервис Microsoft ImagineCare, что позволяет врачам уловить едва заметные перемены в состоянии пациентов. Алгоритмы получают данные об изменениях веса, контролируют давление пациентов и могут даже распознавать эмоциональное состояние на основе анализа телефонных разговоров.

Глубинное обучение применяется и в фармацевтике. Сегодня для лечения разных видов рака используется молекулярно-таргетная терапия. Но для создания эффективного и безопасного лекарства необходимо идентифицировать активные молекулы, которые бы воздействовали только на заданную мишень, позволяя избежать побочных эффектов. Поиск таких молекул может выполняться с использованием глубинного обучения (описание проекта, проведенного совместно учеными из университетов Австрии, Бельгии и R&D-отдела компании Johnson&Johnson есть в этом научном материале).

Есть ли у алгоритма интуиция?

Насколько на самом деле «глубоко» глубинное обучение? Ответ на это вопрос могут дать разработчики AlphaGo. Этот алгоритм не умеет говорить, не умеет распознавать эмоции. Но он способен обыграть любого в настольную игру. На первый взгляд тут нет ничего особенного. Уже почти 20 лет назад компьютер, разработанный IBM, впервые обыграл в шахматы человека. Но AlphaGo – совсем другое дело. Настольная игра Го появилась в Древнем Китае. Начало чем-то похоже на шахматы – противники играют на доске в клетку, черные фигуры против белых. Но на этом сходства заканчиваются, потому что фигуры являются небольшими камушками, а цель игры – окружить камушек противника своими.

Но главное отличие в том, что не существует каких-либо заранее известных выигрышных комбинаций, в го невозможно думать на несколько ходов вперед. Машину нельзя запрограммировать на победу, потому что невозможно выстроить победную стратегию заранее. Здесь и вступает в игру глубинное обучение. Вместо программирования определенных ходов, AlphaGo проанализировала сотни тысяч сыгранных партий и сыграла миллион партий сама с собой. Искусственный интеллект может обучаться на практике и выполнять сложные задания, приобретая то, что человек назвал бы «интуитивным пониманием выигрышной стратегии».

Машины не захватят мир

Несмотря на ошеломляющие успехи AlphaGo, искусственный интеллект еще далек от порабощения человеческой расы. Машины научились своеобразному «интуитивному мышлению», обработке огромного массива данных, но, по словам Фей-Фей Ли, руководителя Стэнфордской лаборатории искусственного интеллекта, абстрактное и творческое мышление им недоступно.

Несмотря на определенный прогресс в распознавании изображений, компьютер может перепутать дорожный знак с холодильником. Вместе со своими коллегами Ли составляет базу изображений с их подробным описанием и большим количеством тегов, которые позволят компьютеру получить больше информации о реальных объектах.

По словам Ли, такой подход – обучение на основе фото и подробного его описания – похож на то, как учатся дети, ассоциируя слова с объектами, отношениями и действиями. Конечно, эта аналогия довольно грубая – ребенку для понимания взаимосвязей объектов реального мира не нужно дотошно описывать каждый предмет и его окружение.

Профессор Джош Тененбаум, изучающий когнитивистику в MIT, отмечает, что, алгоритм познания мира и обучения у компьютера сильно отличается от процесса познания у человека; несмотря на свой размер, искусственные нейронные сети не могут сравниться с устройством биологических сетей. Так, способность говорить формируется в человеке очень рано и базируется на визуальном восприятии мира, владении опорно-двигательным аппаратом. Тененбаум уверен, что научить машины полноценному мышлению без подражания человеческой речи и психологической составляющей не представляется возможным.

Фей-Фей Ли согласна с этим мнением. По словам ученой, современный уровень работы с искусственным интеллектом не позволит приблизить его к человеческому – как минимум за счет наличия у людей эмоционального и социального интеллекта. Поэтому захват мира машинами стоит отложить как минимум еще на пару десятилетий.